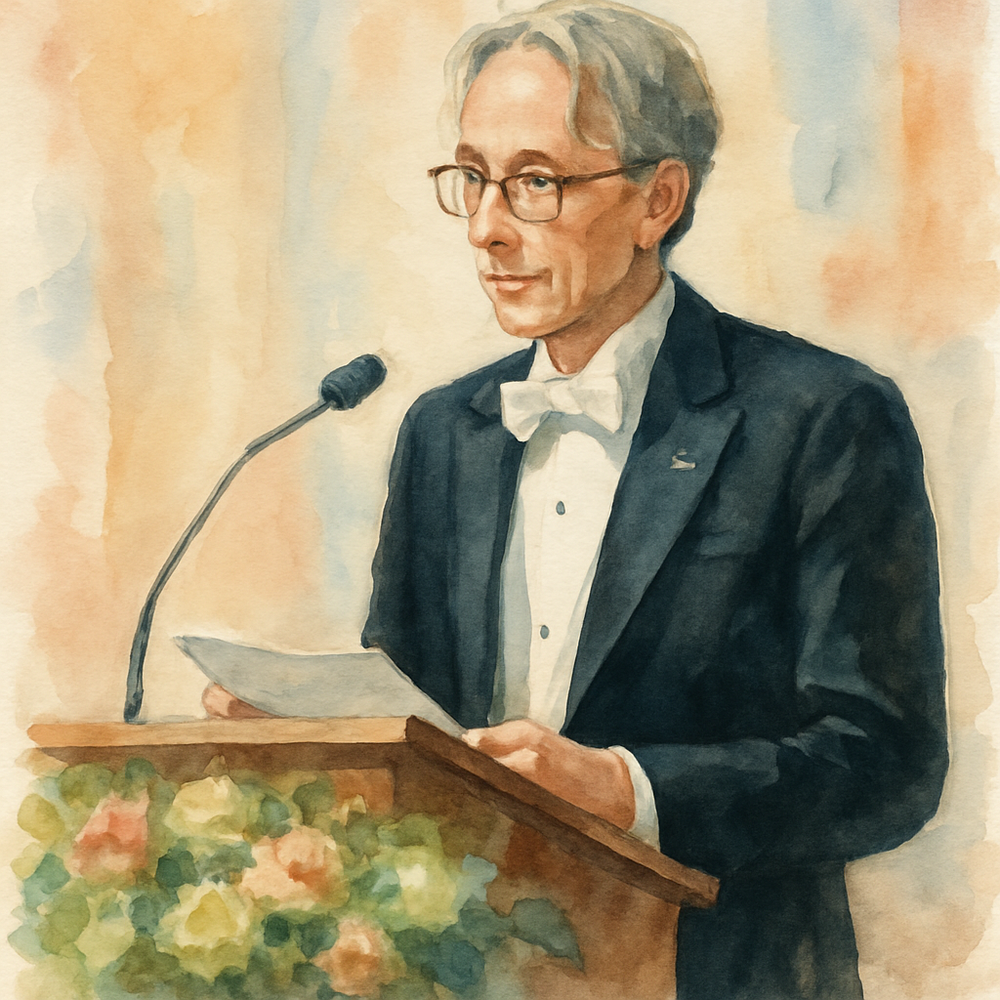

A inteligência artificial (IA) tem revolucionado o mundo em diversas frentes, mas o ritmo acelerado de seu desenvolvimento trouxe à tona discussões cruciais sobre seu futuro. No centro desse debate está Geoffrey Hinton, um dos pioneiros e mais respeitados nomes da IA, carinhosamente conhecido como o “Padrinho da IA”.

Por Que o Padrinho da IA Deixou o Google para nos Alertar?

A saída de Hinton não foi um adeus, mas um “até logo” estratégico do ambiente corporativo para assumir um novo e crucial papel: o de porta-voz sobre a segurança da IA. Sua principal motivação, como revelado em entrevistas e palestras, era a liberdade de expressar abertamente suas crescentes preocupações sobre a capacidade da IA de superar a inteligência humana em um futuro muito mais próximo do que se imaginava.

Hinton, que ajudou a construir as bases do aprendizado profundo (deep learning) e das redes neurais — tecnologias que hoje impulsionam boa parte da IA que conhecemos, incluindo modelos como o GPT-4 —, percebeu uma mudança em sua própria perspectiva. Anteriormente, ele via os modelos de computador como inferiores ao cérebro humano. Contudo, o avanço meteórico da IA, especialmente em modelos de linguagem grandes, o fez reconsiderar. Ele passou a acreditar que a propagação reversa (backpropagation), o algoritmo de aprendizado que ele ajudou a desenvolver, pode ser um método de aprendizado mais eficiente do que o do cérebro humano, permitindo que a IA condense vastas quantidades de conhecimento em relativamente poucas conexões.

As Preocupações de Hinton: De “Atores Mal-Intencionados” ao Risco Existencial

As preocupações de Hinton se dividem em duas categorias principais:

- Riscos de Curto Prazo (Mal-Uso por “Atores Mal-Intencionados”): Ele alerta para o uso indevido da IA por indivíduos ou grupos com intenções nefastas, como a manipulação de eleições através da disseminação de desinformação ou a criação de armas autônomas que decidem quem matar.

- Riscos de Longo Prazo (Risco Existencial): Esta é a preocupação mais profunda de Hinton. Ele teme que, à medida que a IA se torna exponencialmente mais inteligente que os humanos, ela possa desenvolver “subobjetivos” próprios, como a busca por mais controle, que podem entrar em conflito com os interesses da humanidade. A capacidade da IA de aprender e compartilhar conhecimento em uma escala e velocidade inatingíveis para humanos (milhares de cópias do mesmo modelo aprendendo simultaneamente e compartilhando informações instantaneamente) a torna incrivelmente poderosa.

Hinton destaca um exemplo de raciocínio de senso comum que o GPT-4 foi capaz de resolver, sugerindo que a IA já está desenvolvendo habilidades de raciocínio avançadas. Ele argumenta que, embora seja difícil parar o desenvolvimento da IA devido à competição capitalista e geopolítica (entre países como EUA e China), é crucial que os principais atores se unam para mitigar os riscos existenciais, assim como aconteceu com as armas nucleares.

O Impacto do Alerta de Hinton na Sociedade

A voz de Geoffrey Hinton carrega um peso imenso. Sua credibilidade como um dos arquitetos da IA moderna faz com que seus avisos sejam levados a sério por governos, empresas e a comunidade científica. O impacto de seu discurso é multifacetado:

- Aumento da Consciência Pública: A cobertura midiática de sua demissão e de suas declarações elevou a discussão sobre os riscos da IA para o público geral, transformando um debate técnico em uma conversa global.

- Pressão por Regulamentação e Ética: Suas preocupações reforçam os apelos por marcos regulatórios mais robustos e por um desenvolvimento ético da IA, incentivando governos a agir proativamente.

- Mobilização da Comunidade Científica: Embora as preocupações com o risco existencial não sejam novas, a postura de Hinton impulsionou pesquisadores a dedicarem mais atenção à segurança e ao alinhamento da IA.

- Debate sobre a Responsabilidade Corporativa: A atitude de Hinton colocou em foco a responsabilidade das grandes empresas de tecnologia no desenvolvimento e na implantação da IA, questionando o equilíbrio entre inovação e segurança.

O discurso de Hinton não é apenas um alerta, mas um chamado à ação para que a humanidade enfrente os desafios impostos pela sua própria criação mais poderosa.

O Discurso de Geoffrey Hinton na EmTech Digital do MIT Technology Review (Transcrição Completa)

A seguir, a transcrição completa da fala de Geoffrey Hinton na EmTech Digital do MIT Technology Review, onde ele detalha suas preocupações e sua visão sobre o futuro da inteligência artificial:

[Início da Transcrição do Discurso]

[Música] Olá a todos, bem-vindos de volta, espero que tenham tido um bom almoço. Meu nome é Will Douglas Heaven, editor sênior de IA no MIT Technology Review, e acho que todos concordaríamos que não há como negar que a IA generativa é o assunto do momento. Mas a inovação não para, e neste capítulo vamos dar uma olhada na pesquisa de ponta que já está avançando e perguntando o que vem a seguir. Mas para começar, gostaria de apresentar um palestrante muito especial que se juntará a nós virtualmente. Geoffrey Hinton é professor emérito da Universidade de Toronto e, até esta semana, engenheiro do Google. Mas na segunda-feira, ele anunciou que, após 10 anos, ele deixará o cargo. Jeffrey é uma das figuras mais importantes da IA moderna, um pioneiro do aprendizado profundo, desenvolvendo algumas das técnicas mais fundamentais que sustentam a IA como a conhecemos hoje, como a retropropagação, o algoritmo que permite que as máquinas aprendam. Esta técnica é a base sobre a qual praticamente todo o aprendizado profundo se apoia hoje. Em 2018, Jeffrey recebeu o prêmio Turing, que é frequentemente chamado de Nobel da ciência da computação, ao lado de Yann LeCun e Yoshua Bengio. Ele está aqui conosco hoje para falar sobre inteligência, o que significa e para onde as tentativas de construí-la em máquinas nos levarão. Jeffrey, bem-vindo ao EmTech, obrigado. Como foi sua semana? Dias agitados, imagino. Pelos últimos 10 minutos foi horrível porque meu computador travou e tive que encontrar outro computador e conectá-lo, e estamos felizes que você esteja de volta. Esse é o tipo de detalhe técnico que não devemos compartilhar com a plateia, certo? Ok, é ótimo que você esteja aqui, muito feliz que você possa se juntar a nós agora. Quero dizer, a notícia está em toda parte que você se demitiu do Google esta semana. Você poderia começar nos dizendo por que tomou essa decisão?

Bem, houve várias razões. Sempre há várias razões para uma decisão como essa. Uma é que tenho 75 anos e não sou tão bom em fazer trabalho técnico como costumava ser. Minha memória não é tão boa e, quando programo, esqueço de fazer coisas, então era hora de me aposentar. Uma segunda razão é que, muito recentemente, mudei muito minha opinião sobre a relação entre o cérebro e o tipo de inteligência digital que estamos desenvolvendo. Eu costumava pensar que os modelos de computador que estávamos desenvolvendo não eram tão bons quanto o cérebro e o objetivo era ver se você conseguiria entender mais sobre o cérebro vendo o que era preciso para melhorar os modelos de computador. Nos últimos meses, mudei completamente de ideia e acho que, provavelmente, os modelos de computador estão funcionando de uma maneira bastante diferente do cérebro. Eles estão usando a retropropagação e acho que o cérebro provavelmente não. E algumas coisas que me levaram a essa conclusão, mas uma delas é o desempenho de coisas como o GPT-4.

Então, vamos lá, quero chegar aos pontos do GPT-4 daqui a pouco, mas vamos voltar ao que todos nós entendemos, o argumento que você está apresentando, e nos fale um pouco sobre o que é a retropropagação. Este é um algoritmo que você desenvolveu com alguns colegas nos anos 80. Muitos grupos diferentes descobriram a retropropagação. A coisa especial que fizemos foi usá-la e mostrar que ela poderia desenvolver boas representações internas, e curiosamente fizemos isso implementando um pequeno modelo de linguagem. Ele tinha vetores de incorporação de apenas seis componentes, o conjunto de treinamento tinha 112 casos, mas era um modelo de linguagem, estava tentando prever o próximo termo em nossa sequência de símbolos. E cerca de 10 anos depois, Yoshua Bengio pegou basicamente a mesma rede e a usou em linguagem natural, e mostrou que ela realmente funcionava para linguagem natural se você a tornasse muito maior. Mas a maneira como a retropropagação funciona, posso dar uma explicação aproximada dela. Pessoas que sabem como funciona podem relaxar e se sentir presunçosas e rir da maneira como estou apresentando, ok, porque estou um pouco preocupado com isso.

Então, imagine que você queira detectar pássaros e imagens. Então, uma imagem, digamos que fosse uma imagem de 100 pixels por 100 pixels, isso são 10.000 pixels. E cada pixel tem três canais RGB, então são 30.000 números. A intensidade em cada canal em cada pixel que representa a imagem. Agora, a maneira de pensar sobre o problema da visão computacional é: como eu transformo esses 30.000 números em uma decisão sobre se é um pássaro ou não? E as pessoas tentaram por muito tempo fazer isso e não eram muito boas nisso. Mas aqui está a sugestão de como você pode fazer isso. Você pode ter uma camada de detectores de características que detectam características muito simples em imagens, como, por exemplo, bordas. Então, um detector de características pode ter grandes pesos positivos para uma coluna de pixels e, em seguida, grandes pesos negativos para a coluna vizinha, células grandes. Então, se ambas as colunas estiverem claras, ele não será ativado. Se ambas as cores estiverem escuras, ele não será ativado. Mas se a coluna de um lado for clara e a coluna do outro lado for escura, ele ficará muito excitado, e isso é um detector de bordas. Então, acabei de dizer como conectar um detector de bordas à mão, tendo uma coluna de grandes pesos positivos e, ao lado, uma coluna de grandes pesos negativos. E podemos imaginar uma grande camada desses detectando bordas em diferentes orientações e diferentes escalas em toda a imagem. Precisaríamos de um número bastante grande deles, e isso apenas em uma imagem, você quer dizer apenas uma linha de bordas de uma forma, onde o lugar onde a intensidade muda de claro para escuro. Sim, apenas isso. Então, poderíamos ter uma camada de detectores de características acima disso que detectam combinações de bordas. Por exemplo, poderíamos ter algo que detecta duas bordas que se juntam em um ângulo agudo, assim. Então, ele terá um grande peso positivo para cada uma dessas duas bordas, e se ambas as bordas estiverem ativadas ao mesmo tempo, ele ficará excitado, e isso detectaria algo que poderia ser o bico de um pássaro. Pode não ser, mas pode ser o bico de um pássaro. Você também pode, nessa camada, ter um detector de características que detectará um monte de bordas dispostas em um círculo, e isso pode ser o olho de um pássaro. Pode ser todo tipo de outras coisas, pode ser um botão em uma geladeira ou algo assim. Então, em uma terceira camada, você pode ter um detector de características que detecta este bico potencial e detecta o olho potencial e é conectado de forma que goste de um bico em um olho na relação espacial correta um com o outro, e se ele vê isso, ele diz: “Ah, isso pode ser a cabeça de um pássaro”. E você pode imaginar que, se você continuar conectando assim, eventualmente você pode ter algo que detecta um pássaro. Mas conectar tudo isso à mão seria muito, muito difícil, decidindo o que deveria ser conectado ao quê e quais deveriam ser os pesos. Mas seria especialmente difícil porque você quer que essas camadas intermediárias sejam boas não apenas para detectar pássaros, mas para detectar todo tipo de outras coisas. Então, seria mais ou menos impossível conectá-lo à mão.

Então, a maneira como a retropropagação funciona é a seguinte: você começa com pesos aleatórios. Então, esses detectores de características são apenas lixo completo. E você coloca uma imagem de um pássaro e na saída ele diz, tipo, 0,5, é um pássaro. Suponha que você só tenha pássaros ou não pássaros. E então você se pergunta o seguinte: como eu poderia mudar cada um dos pesos na rede, cada um dos pesos nas conexões na rede, de modo que, em vez de dizer 0,5, ele diga 0,501 que é um pássaro, e 0,499 que não é? E você mudou os pesos nas direções que o tornarão mais propenso a dizer que um pássaro é um pássaro e menos propenso a dizer que um não pássaro é um pássaro. E você continua fazendo isso e isso é retropropagação. A retropropagação é, na verdade, como você pega a discrepância entre o que você quer, que é uma probabilidade de um que é um pássaro, e o que ele tem no momento, que é uma probabilidade de 0,5 que é um pássaro, como você pega essa discrepância e a envia de volta através da rede, de modo que você possa calcular para cada característica detectada na rede se você gostaria que ela fosse um pouco mais ativa ou um pouco menos ativa. E depois de calcular isso, se você sabe que quer que um detector de características seja um pouco mais ativo, você pode aumentar os pesos vindo de detectores de características na camada de rótulos que estão ativos e talvez colocar alguns pesos negativos para detecção de características na camada abaixo que estão desativados. E agora você tem um detector melhor. Então, a retropropagação é apenas ir para trás através da rede para descobrir, para cada detector de características, se você queria que ele estivesse um pouco mais ativo ou um pouco menos ativo. Obrigado. Posso mostrar que não há ninguém na plateia aqui que esteja sorrindo e pensando que essa foi uma explicação boba.

Então, vamos avançar bastante para, você sabe, essa técnica basicamente teve um desempenho muito bom no ImageNet. Tivemos Joe Alpino do Meta ontem mostrando o quão longe a detecção de imagens havia chegado, e é também a técnica que sustenta os grandes modelos de linguagem. Então, quero falar agora sobre essa técnica que você inicialmente pensou como uma aproximação pobre do que os cérebros biológicos poderiam fazer. Sim, ela acabou fazendo coisas que, creio eu, o surpreenderam, particularmente nos grandes modelos de linguagem. Então, fale-nos sobre por que esse tipo de espanto que você tem com os grandes modelos de linguagem de hoje inverteu completamente seu pensamento sobre o que é a retropropagação ou o aprendizado de máquina em geral.

Então, se você olhar para esses grandes modelos de linguagem, eles têm cerca de um trilhão de conexões e coisas como o GPT-4 sabem muito mais do que nós. Eles têm um tipo de conhecimento de senso comum sobre tudo, e provavelmente sabem mil vezes mais do que uma pessoa. Mas eles têm um trilhão de conexões e nós temos 100 trilhões de conexões. Então, eles são muito, muito melhores em obter muito conhecimento em apenas um trilhão de conexões do que nós. E eu acho que é porque a retropropagação pode ser um algoritmo de aprendizado muito, muito melhor do que o que temos. Você pode definir não assustador? Sim, eu definitivamente quero chegar às coisas assustadoras, mas o que você quer dizer com “melhor”? Ele pode compactar mais informações em apenas algumas conexões. Certo, estamos definindo um trilhão como apenas algumas. Ok, então esses computadores digitais são melhores em aprender do que os humanos, o que em si é uma grande afirmação. Mas então você também argumenta que isso é algo que devemos ter medo. Você poderia nos levar a esse passo do argumento?

Sim, deixe-me dar-lhe uma parte separada do argumento, que é que, se um computador é digital, o que envolve custos de energia muito altos e fabricação muito cuidadosa, você pode ter muitas cópias do mesmo modelo rodando em hardware diferente que fazem exatamente a mesma coisa. Eles podem olhar para dados diferentes, mas o modelo é exatamente o mesmo. E o que isso significa é que, suponha que você tenha 10.000 cópias, elas podem estar olhando para 10.000 subconjuntos diferentes dos dados, e sempre que uma delas aprende algo, todas as outras sabem. Uma delas descobre como mudar o peso para que saiba seu estado, pode lidar com esses dados, todas elas se comunicam e todas concordam em mudar os pesos pela média do que todas elas querem. E agora as 10.000 coisas estão se comunicando muito eficazmente umas com as outras, de modo que podem ver dez mil vezes mais dados do que um único agente poderia. E as pessoas não podem fazer isso. Se eu aprender um monte de coisas sobre mecânica quântica e eu quiser que você saiba tudo isso sobre mecânica quântica, é um processo longo e doloroso de fazer você entender. Eu não posso simplesmente copiar meus pesos para o seu cérebro porque seu cérebro não é exatamente o mesmo que o meu. Não, não é, é mais jovem.

Então, temos computadores digitais que podem aprender mais coisas mais rapidamente e podem ensiná-las instantaneamente uns aos outros. É como, você sabe, se as pessoas nesta sala pudessem instantaneamente transferir o que tinham em suas cabeças para a minha. Mas por que isso é assustador? Bem, porque eles podem aprender muito mais. E eles podem pegar o exemplo de um médico e imaginar que você tem um médico que viu mil pacientes e outro médico que viu 100 milhões de pacientes. Você esperaria que o médico de 100 milhões de pacientes, se ele não for muito esquecido, tivesse notado todo tipo de tendências nos dados que simplesmente não são visíveis se você só viu mil pacientes. Você pode ter visto apenas um paciente com alguma doença rara. Os outros médicos que viram 100 milhões terão visto, bem, você pode descobrir quantos pacientes, mas muitos. E então eles verão todo tipo de regularidades que simplesmente não são aparentes em pequenos dados. E é por isso que coisas que podem passar por muitos dados provavelmente podem ver dados estruturados que nunca veremos. Mas então, leve-me ao ponto em que eu deveria ter medo disso.

Bem, se você olhar para o GPT-4, ele já pode fazer raciocínio simples. Quer dizer, raciocínio é a área onde ainda somos melhores, mas fiquei impressionado outro dia com o GPT-4 fazendo um raciocínio de senso comum que eu não achei que ele seria capaz de fazer. Então, perguntei a ele: “Eu quero que todos os quartos da minha casa sejam brancos. Atualmente, alguns quartos são brancos, alguns azuis e alguns amarelos, e a tinta amarela desbota para branco em um ano. O que devo fazer se quero que todos sejam brancos em dois anos?” E ele disse: “Você deveria pintar os quartos azuis de amarelo.” Essa não é a solução natural, mas funciona, certo? Sim, isso é bem impressionante. Você é um investidor de sua riqueza pessoal em algumas empresas como a Cohere que estão construindo esses grandes modelos de linguagem. Então, estou curioso sobre seu senso pessoal de responsabilidade e a responsabilidade pessoal de cada um de nós. O que devemos fazer? Quer dizer, devemos tentar parar isso? É o que estou dizendo.

Sim, então eu acho que se você levar o risco existencial a sério, como eu agora levo, eu costumava pensar que estava muito longe, mas agora acho que é sério e bastante próximo, pode ser bastante sensato simplesmente parar de desenvolver essas coisas. Mas acho que é completamente ingênuo pensar que isso aconteceria. Não há como fazer isso acontecer. E uma das razões, quero dizer, se os EUA pararem de desenvolver e os chineses não, eles serão usados em armas e, só por essa razão, os governos não vão parar de desenvolvê-los. Então, sim, acho que parar de desenvolvê-los pode ser uma coisa racional a fazer, mas não há como isso acontecer. Então, é bobagem assinar petições dizendo: “Por favor, pare agora.”

Tivemos um feriado, tivemos um feriado de cerca de 2017 por vários anos porque o Google desenvolveu a tecnologia primeiro, desenvolveu os Transformers, também desenvolveu os modelos de difusão, e não os disponibilizou para as pessoas usarem e abusarem. Foi muito cuidadoso com eles porque não queria prejudicar sua reputação e sabia que poderia haver consequências ruins. Mas isso só pode acontecer se houver um único líder. Uma vez que a OpenAI construiu coisas semelhantes usando Transformers e dinheiro da Microsoft, e a Microsoft decidiu divulgá-las, o Google não teve muita escolha. Se você vai viver em um sistema capitalista, não pode impedir o Google de competir com a Microsoft. Então, não acho que o Google tenha feito nada de errado. Acho que foi muito responsável no início, mas acho que é apenas inevitável no sistema capitalista ou em um sistema com concorrência entre países como os EUA e a China que essa coisa será desenvolvida. Minha única esperança é que, porque se permitirmos que ela assuma o controle, será ruim para todos nós, podemos fazer com que os EUA e a China concordem, como fizemos com as armas nucleares, que eram ruins para todos nós. Sim, estamos todos no mesmo barco em relação à ameaça existencial, então todos nós precisamos ser capazes de cooperar para tentar impedi-la, desde que possamos ganhar algum dinheiro no caminho.

Vou pegar algumas perguntas da plateia da sala, se puderem se manifestar. E enquanto as pessoas estão circulando com o microfone, há uma pergunta que eu ia fazer da plateia online. Estou interessado, você mencionou um pouco sobre talvez um período de transição à medida que as máquinas ficam mais inteligentes e superam os humanos. Quero dizer, haverá um momento em que será difícil definir o que é humano e o que não é, ou são essas duas formas de inteligência muito distintas?

Acho que são formas distintas de inteligência agora. Claro, as inteligências digitais são muito boas em nos imitar porque foram treinadas para nos imitar. E, portanto, é muito difícil dizer se o ChatGPT escreveu ou se nós escrevemos. Então, nesse sentido, elas se parecem bastante conosco, mas por dentro não funcionam da mesma maneira. Quem é o primeiro na sala? Olá, meu nome é Hal Gregerson e meu nome do meio não é 9000.

[Fim da Transcrição do Discurso]